IA, Cloud, Cybersécurité

SLM vs LLM : Pourquoi l'IA en entreprise passe par les Small Models

Publié le 22 novembre 2025 par Julien CIULLO

L'année 2023 a été marquée par la course à la taille : des modèles toujours plus massifs (LLM), gourmands en paramètres et en puissance de calcul. Mais pour les Directions des Systèmes d'Information (DSI) et les responsables de la sécurité, cette approche taille unique montre ses limites : coûts d'inférence prohibitifs, latence et, surtout,risques majeurs pour la confidentialité des données. En 2025, le paradigme change. L'innovation ne réside plus dans la taille du modèle, mais dans son efficience. Entrent en scène les Small Language Models (SLM). Plus agiles, sécurisés et spécialisés, ils s'imposent comme la solution pragmatique pour intégrer l'IA générative dans les processus métiers critiques

SLM vs LLM : Pourquoi l’IA en entreprise passe par les “Small Models”

Table des matières

- Introduction

- Qu’est-ce qu’un SLM ? (Et pourquoi la taille compte moins)

- Les 3 avantages stratégiques pour la DSI et la Cybersécurité

- Cas d’usage : Où déployer les SLM dès aujourd’hui ?

- Conclusion : Vers une architecture IA hybride

Introduction

L’année 2023 a été marquée par la course à la taille : des modèles toujours plus massifs (LLM), gourmands en paramètres et en puissance de calcul. Mais pour les Directions des Systèmes d’Information (DSI) et les responsables de la sécurité, cette approche “taille unique” montre ses limites : coûts d’inférence prohibitifs, latence et, surtout, risques majeurs pour la confidentialité des données. En 2025, le paradigme change. L’innovation ne réside plus dans la taille du modèle, mais dans son efficience. Entrent en scène les Small Language Models (SLM). Plus agiles, sécurisés et spécialisés, ils s’imposent comme la solution pragmatique pour intégrer l’IA générative dans les processus métiers critiques.

Qu’est-ce qu’un SLM ? (Et pourquoi la taille compte moins)

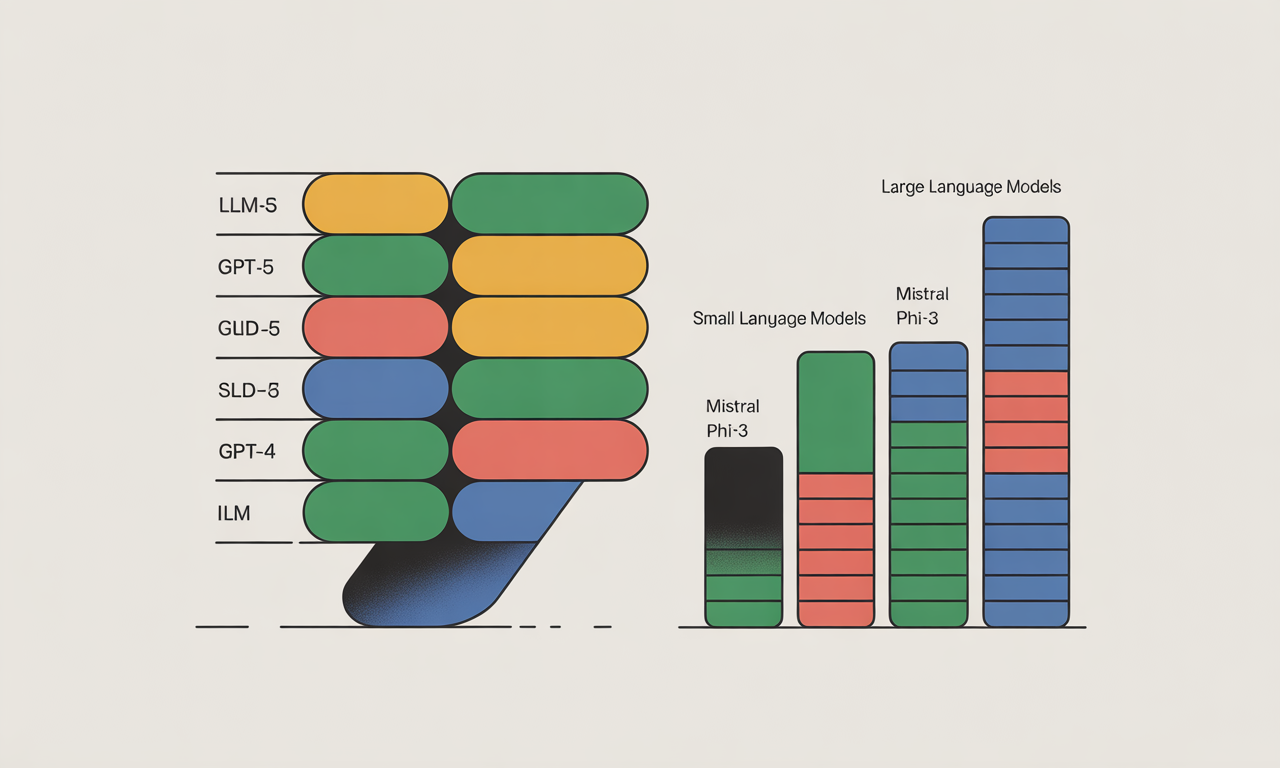

Contrairement aux LLM (Large Language Models) qui dépassent souvent les 100 milliards de paramètres, les SLM se situent généralement entre 1 et 10 milliards de paramètres. La magie des SLM réside dans leur méthode d’entraînement. Au lieu d’ingérer l’intégralité du web sans distinction, ils sont entraînés sur des jeux de données de haute qualité, curés et synthétiques. C’est la différence entre un encyclopédiste généraliste moyen et un expert pointu qui a lu les meilleurs manuels techniques. Des modèles récents comme Phi-3 de Microsoft, Gemma de Google ou les versions compactes de Mistral prouvent qu’à taille réduite, les performances de raisonnement rivalisent désormais avec des modèles dix fois plus gros sur des tâches spécifiques.

Les 3 avantages stratégiques pour la DSI et la Cybersécurité

Pour un décideur IT, l’adoption des SLM répond à une triple équation insoluble avec les LLM classiques : Sécurité, Coût et Latence.

-

Souveraineté et Confidentialité des données (Privacy-first)

C’est l’argument massue pour les RSSI. Les SLM sont suffisamment légers pour être déployés “On-Premise” (sur site) ou dans un Cloud Privé sécurisé (VPC).

Zéro fuite de données : Vos données propriétaires ne transitent jamais par une API tierce publique.

Conformité : Idéal pour les secteurs régulés (banque, santé, défense) soumis au RGPD ou à des normes strictes de secret industriel. -

Rationalisation des coûts d’infrastructure

L’inférence (l’exécution du modèle) coûte cher. Faire tourner un LLM nécessite des clusters de GPU H100 onéreux. À l’inverse, un SLM bien optimisé peut tourner sur :

Un seul GPU grand public.

Un CPU serveur standard.

Directement sur le poste de travail de l’utilisateur (Edge AI) grâce aux NPU (Neural Processing Units).

Cela transforme l’IA d’un centre de coût variable et imprévisible en un investissement d’infrastructure maîtrisé. -

Latence réduite et efficacité énergétique

Pour des applications temps réel, attendre 3 secondes pour une réponse est inacceptable. Les SLM offrent une latence minime, essentielle pour l’expérience utilisateur ou les processus industriels. De plus, leur empreinte carbone est drastiquement inférieure, s’alignant avec les objectifs RSE des entreprises.

Cas d’usage : Où déployer les SLM dès aujourd’hui ?

L’objectif n’est pas de demander à un SLM d’écrire un poème, mais d’exécuter des tâches métiers précises.

A. L’Assistant de Code Sécurisé (DevSecOps)

Les entreprises hésitent à connecter leurs IDE à des assistants IA cloud de peur d’exposer leur code source. Un SLM spécialisé dans le code (fine-tuné sur le stack technique de l’entreprise) peut tourner localement sur la machine du développeur, offrant auto-complétion et refactoring sans qu’aucune ligne de code ne quitte le réseau local.

B. L’Intelligence Embarquée (Edge AI) et IoT

Imaginez un technicien de maintenance en zone blanche ou sur un site industriel sensible. Il peut interroger une documentation technique massive via un SLM embarqué directement sur sa tablette durcie, sans connexion internet. Le modèle répond instantanément aux questions sur les procédures de réparation.

C. Analyse Documentaire Juridique et RH

Pour analyser des milliers de contrats ou de CVs, inutile d’avoir une culture générale mondiale. Un SLM entraîné spécifiquement sur le droit des affaires ou la terminologie RH sera plus performant, moins sujet aux “hallucinations” et garantira que les données personnelles restent en interne.

Conclusion : Vers une architecture IA hybride

L’avenir de l’IA en entreprise n’est pas binaire. Nous nous dirigeons vers une architecture hybride : les LLM géants dans le cloud pour les tâches créatives complexes et généralistes, et une constellation de SLM spécialisés, locaux et sécurisés pour les processus métiers quotidiens. Pour les DSI, l’enjeu actuel est d’identifier les flux de données qui nécessitent cette approche locale pour gagner en indépendance technologique et en efficience économique.

Pour aller plus loin

Cet article est lié à l'un de nos domaines d'expertise.